现在已经是3月中旬了,我们这次推荐一些2月和3月发布的论文。

Why do Learning Rates Transfer? Reconciling Optimization and Scaling Limits for Deep Learning.

https://arxiv.org/abs/2402.17457

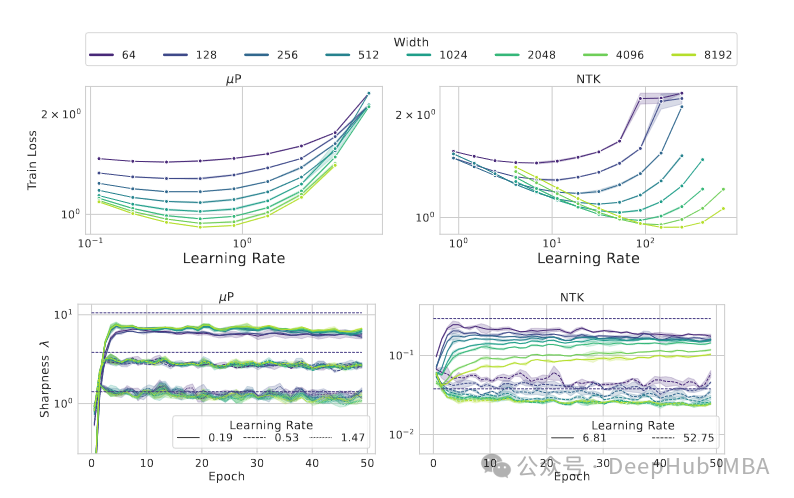

学习速率为什么会迁移?本研究试图从理论上解释MuP超参数传递的成功之处。根据其创作者的说法,训练损失的Hessian矩阵的最大特征值不受网络深度或广度的影响。

https://avoid.overfit.cn/post/8a1f17f10c7f43ec93afb3abd0f3a14c

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。